Добрый день! Сегодня ознакомлю вас с одним из своих любимых SEO-инструментов, который я очень часто использую в своей работе. Это программа SERP Parser, который позволяет снимать позиции сайта.

Многие, особенно начинающие, скажут/подумают: “Зачем мне снимать позиции, я же не профессиональный оптимизатор”. Но знание тех “ключей”, которые находятся в ТОП-50 (именно они очень ценны), может оказаться “под руку”. Их проще продвинуть в ТОП-10, нежели другие запросы. Да и, если мы постоянно работаем над сайтом, мы должны знать: правильно ли мы все делаем, есть ли рост позиций?

Также встречается следующий вопрос, который вызывает затруднение: “А где мне взять эти ключи, по которым нужно снимать позиции?” . Отвечаю, как делаю это я:

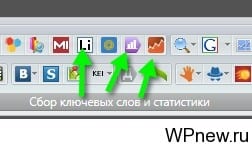

- Открываю свою любимую SEO программу KeyCollector (конечно, следующие действия можно производить вручную).

- Там есть 3 замечательные кнопки, которые помогают выгрузить ключевые слова, по которым заходят на наш сайт. Выгружаем эти ключевые слова (если Вы пользуетесь только одним из сервисов – Liveinternet, Яндекс Метрика или Google Analytics – тоже достаточно):

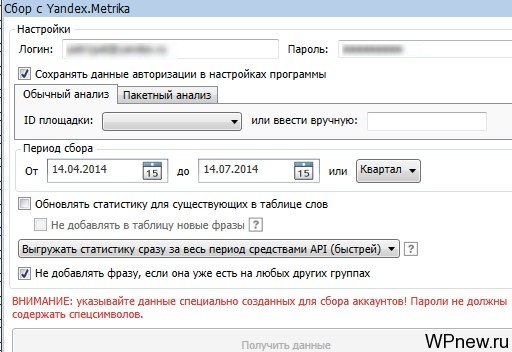

- Обычно я снимаю “ключевики” за последний квартал:

- Из полученного огромного количество ключевых слов, нужно “выкинуть мусор”. Я снимаю у полученных слов точную частотность (снова Кейколлектор, если его нет, можете использовать СловоЁб). Частотность у которых меньше определенного количества (смотря сколько ключей в итоге надо), автоматически удаляю.

- Из оставшихся снова все перебираю и оставляю только необходимые запросы.

Итак, вернемся к “Серп Парсеру”. Хочу отметить, что данный инструмент я действительно использую постоянно и данный обзор не является “заказным”. Я долгое время выбирал чем и как снять позиции сайта. Для меня было важно, чтобы информация была:

- актуальной, позиции отображались правильно;

- бесплатной или максимально дешевой;

- наглядно демонстрирующей позиции сайта для предоставления отчетов клиентам.

Как оказалось, многие программы работали не совсем правильно: я присылаю отчет клиенту, что сайт по данному запросу находится на 6-ой позиции допустим, а на самом деле он оказывается на 11-ой. Попадал немного в неприятные ситуации. Конечно, тут надо помнить о персонализированном поиске, чтобы узнать на каком месте действительно находится ваш сайт по какому-либо запросу, нужно перейти в режим “Инкогнито” в Google Chrome (Ctrl+Shift+N), ввести запрос, указать необходимый регион и смотреть.

SERP Parser проявила себя как программа, которая полностью удовлетворяет моим этим основным трем потребностям. Она бесплатная первые 14 дней. Можете воспользоваться всеми прелестями ее за этот период, снять позиции сайта и решить: стоит ли за нее платить (причем не нужно платить какие-то баснословные деньги, о тарифах – ниже)?

Если вы решились испытать программу, для начала нужно скачать SERP Parser (бесплатно).

План урока по программе SERP Parser:

- Как работать с программой.

- Отчеты SERP Parser.

- Настройки SERP Parser.

- Тарифные планы.

- Использовать SERP Parser или снимать позиции онлайн?

SERP Parser: большая инструкция по применению

Как работать с программой SERP Parser

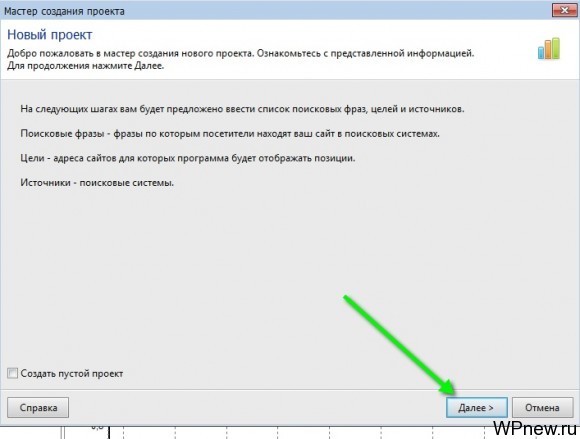

- При первом запуске программа предложит создать новый проект, просто нажимаем “Далее”:

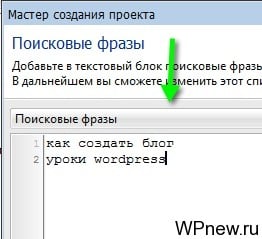

- В следующем окне “вбиваем” ключевые слова вашего сайта (если вы не знаете, какие вбить, прочитайте начало урока еще раз):

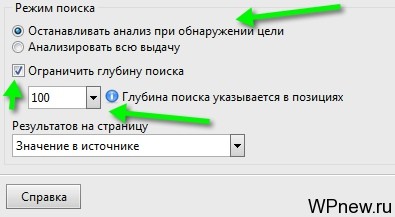

- В том же окне проверяем наличие галочки “Останавливать анализ при обнаружении цели” (зачем нам анализировать всю выдачу?), ограничиваем глубину поиска (я обычно снимаю позиции только для ТОП-100), нажимаем “Далее”:

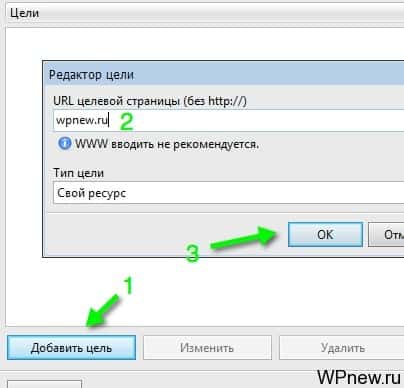

- В следующем окне нажимаем на кнопку “Добавить цель” и “вбиваем” адрес нашего сайта, также можно указать конкурентов, чтобы сравнить себя с ними:

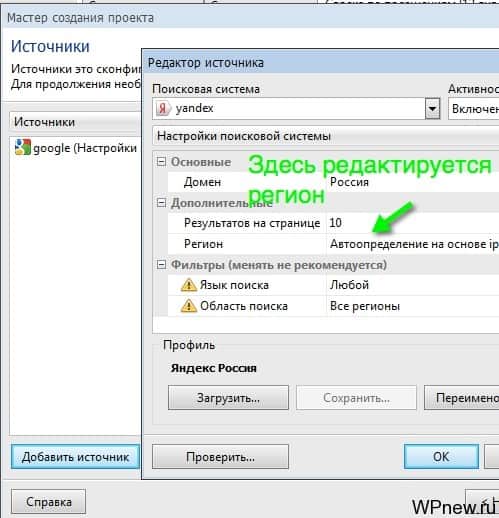

- После того, как нажмете кнопку “Далее”, нужно будет указать “Источники” – поисковые системы, в которых нужно снять позиции. Нажимаем “Добавить”, проставляем Яндекс и Google. Если же у вас геозависимые запросы (кстати, геозависимость запросов я тоже проверяю в Кейколлекторе), то указываем тот регион, в котором продвигается Ваш сайт. Так как мои запросы информационного характера и не привязаны к определенному региону, я не меняю данную настройку:

- При желании, если вы задали регион, можно сохранить данный профиль, чтобы каждый раз не искать “Москва”. В следующий раз можно нажать на кнопку “Загрузить”. Нажимаем “Далее”.

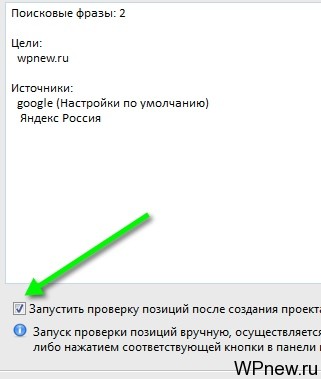

- В следующем окне оставляете отмеченной галочкой “Запустить проверку позиций после создания проекта” и нажимаемете “Ок”:

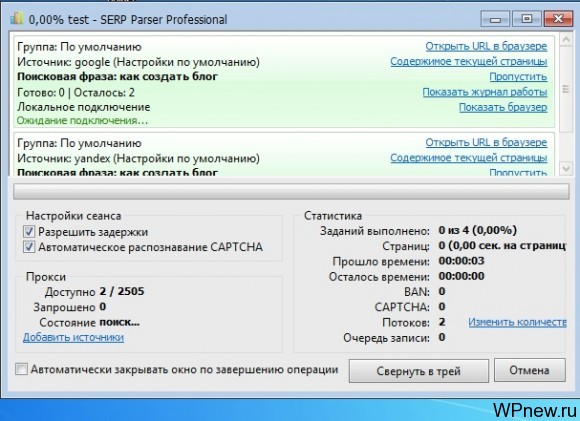

- Программа предложит сохранить проект, даете ему название и сохраняете в нужно месте. После того, как сохраните, пойдет процесс снятия позиций ключевых слов, он выглядит примерно так:

- Идете пить чай. Время снятия позиций сайта зависит от следующих факторов: количество ключевых слов, позиций вашего сайта (помните, что SERP Parser находит вас, к примеру, на 12-ой позиции, переходит к следующему ключу, если вас там не будет, он будет искать во всем ТОП-100), количество “капчей”, “банов”, потоков. О последних трех факторах и как ускорить процесс съема позиций сайта читайте в данном же уроке, пункт “Настройки программы SERP Parser” (чуть ниже).

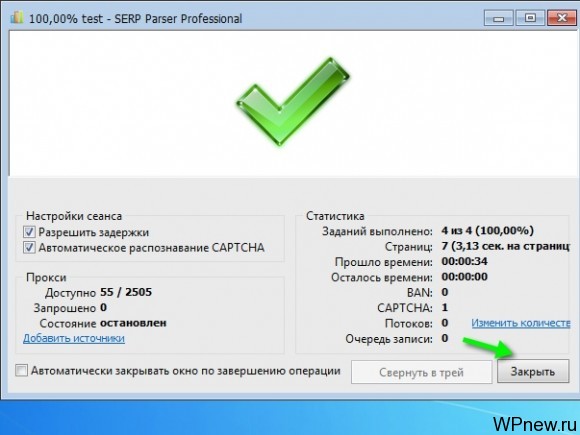

- О том, что съем завершился вы узнаете по следующему сообщению:

- Просто нажимаем на кнопку “Закрыть”. И мы плавно переходим в раздел отчета по данному проекту.

Отчеты в SERP Parser

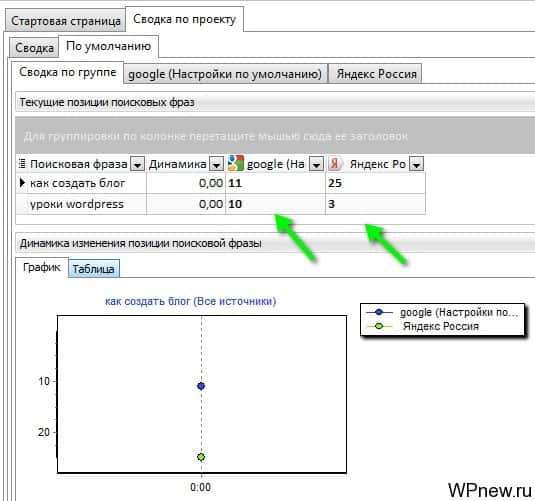

- Сразу же нам в глаза попадет примерно такого вида отчет (стрелочками я указал позиции сайта по запросам):

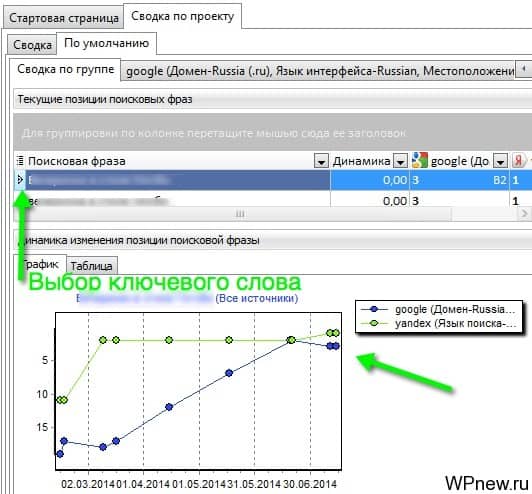

- Если снять позиции после их изменений (допустим, произошел “апдейт” Яндекса (обновление поисковой выдачи) и мы снова сняли позиции), то график внизу примет такой вид (он отображает изменения по каждому ключевому слову, которое нужно предварительно выбрать):

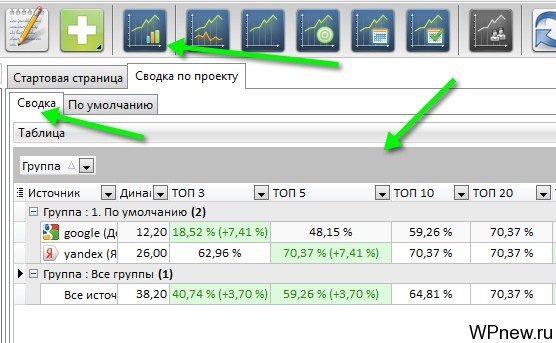

- Нажав на кнопку “Сводка по проекту”, мы видим статистику по всему проекту, всех ключевых слов (сколько процентов от ключей находится в ТОП-3, в ТОП-5 и далее (очень полезно):

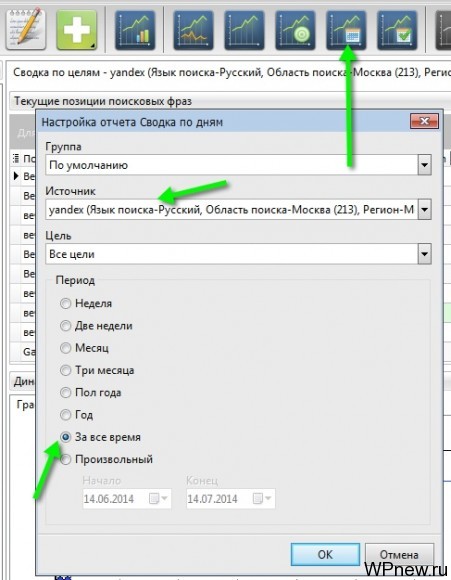

- Клиентам же я отправляю отчет по позициям по датам на каждое конкретное ключевое слово. Для этого нажимаю на кнопку “Сводка по дням”, выбираю поисковую систему (сначала Яндекс, потом Google), ставлю отметку “За все время”:

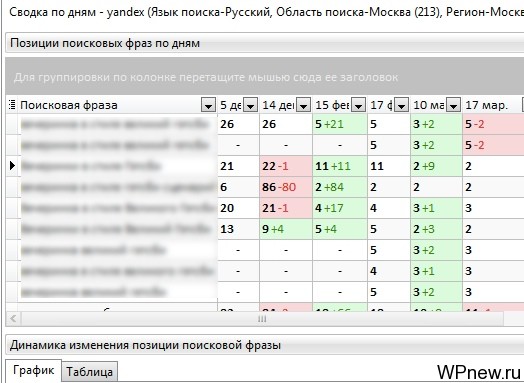

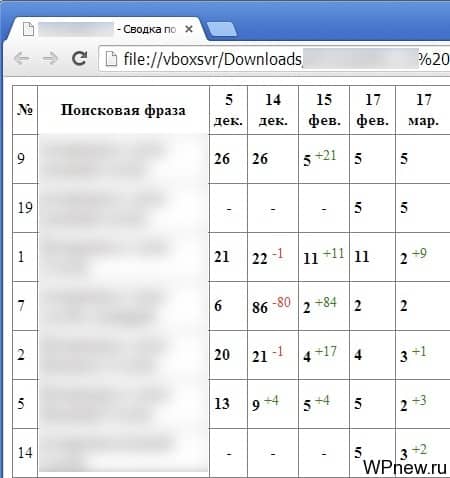

- И видим следующую картину, которая очень наглядно демонстрирует позиции ключей по датам, когда мы снимали их:

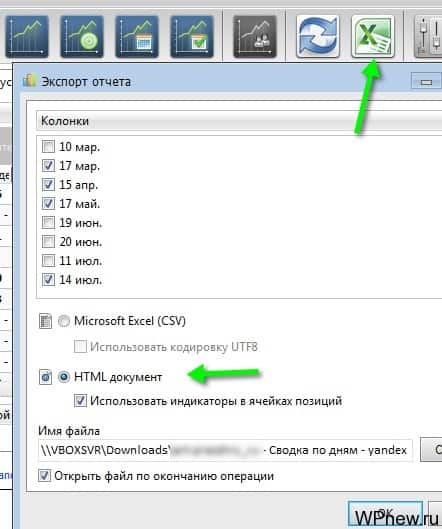

- Экспортирую все это в html формат (если экспортировать в Excel, не будут отображаться значения +1, -3 и т.п.):

- И клиент получает отчет по позициям в таком виде:

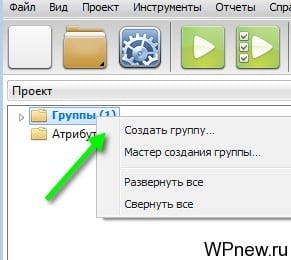

- Все наглядно и удобно, клиентов данный вид отчета по позициям очень даже устраивает. Также вы можете просматривать сводку по группе, по источнику, по целям, по датам. Если же у вас большое количество ключей, их можно разбить на несколько разных групп (категорий), просто создаем новую группу и заносим туда их:

- Помимо всего этого, настоятельно рекомендую ознакомиться с официальной документацией данной замечательной программы, там вы узнаете, что такое “Атрибуты” и многое другое.

Настройки SERP Parser

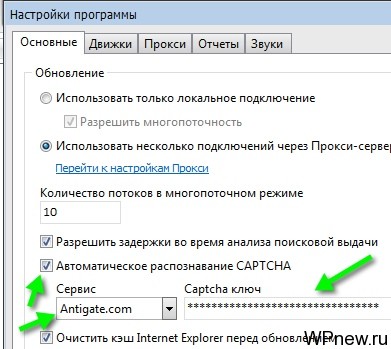

В настройках SERP Parser я практически ничего не трогал, я лишь сделал 3 действия:

- Чтобы не вводить капчу вручную, подключил сервис Antigate, который автоматически распознает капчи (его же я использую в Кейколлекторе).

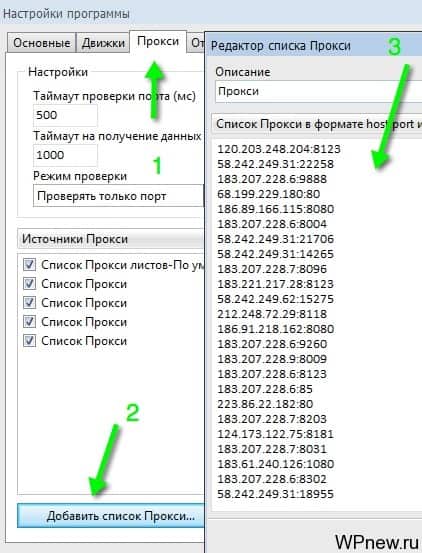

- Чтобы избежать банов и блокировок нашего основного IP адреса компьютера, с которого работаем, прописываем прокси-сервера. То есть запросы с программы SERP Parser будут идти с других IP адресов и наш IP-адрес (свой) блокироваться не будет. Крайне рекомендую прописать прокси-сервера. Я беру их бесплатно тут (постоянно обновляются). Данные строчки просто вставляем сюда:

- Количество потоков при снятии позиций я ставлю 10. Все. Больше никаких настроек в данной программе я не трогаю.

Тарифные планы в SERP Parser

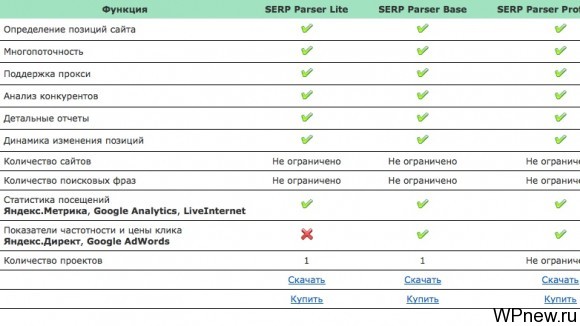

Всего 3 тарифных плана, с помощью любого из них можно снять позиции. Отличия в тарифных планах:

- SERP Parser Lite – возможна работа с 1-им проектом. Цена $9.90 в год. Если вы работаете только с 1-им сайтом – идеальный тарифный план для вас.

- SERP Parser Base – дополнительно отображаются показатели частотности и цены клика (Яндекс.Директ и Google Adwords). Также можно работать только с 1-им проектом. Цена $19.90 в год.

- SERP Parser Professional – все тоже самое, что в предыдущем тарифном плане, но работать уже можно с неограниченным количеством проектов. Цена $29.90 в год. Именно этот тарифный план использую я.

Вот для наглядности:

Как видите цены более чем приемлемы. Для убедительности могу посчитать свою, сколько я экономлю.

Что выбрать: SERP Parser или снимать позиции онлайн?

- Количество запросов, которые я снимаю в течении месяца – минимум 3000.

- Снимаю я позиции в среднем 2 раза в месяц. То есть данную цифру умножаем на 2. Получаем 6000.

- Позиции снимаю в Яндексе и Google, что сказывается на количестве проверок, то есть полученную цифру умножаю на 2. Получаем 12 000 проверок в месяц.

- Возьмем тарифные планы онлайн сервиса Allpositions. Допустим, я бы закинул стоимость программы SERP Parser 1000 рублей в данный сервис. 12 000 проверок * 0.06 руб. = 720 рублей. И это за 1 месяц. То есть в год получаем 8 640 рублей, тогда как за SERP Parser я плачу около 1000 рублей в год! Экономия в 8.6 раз.

- Конечно, тут можно придраться, что не каждый из вас снимает позиций такого количества запросов. Может быть вам хватает и 500 запросов в месяц, снимаете их 1 раз в месяц, допустим. 500*2 (2 поисковые системы) = 1000 * 0.06 руб. = 60 рублей в месяц, либо 720 рублей в год. Выбор за вами.

SERP Parser – это второй софт после KeyCollector’а, который я купил. Причем эти два инструмента полностью оправдывают себя. Каждый рубль. Каждую копейку.

Я все еще не купила KeyCollector. Установила и пока разбираюсь как работает СловоЁб. Серп Парсер заинтересовал, пожалуй скачаю демо. Поиграюсь и посмотрю какая мне польза это этой программы. Спасибо за урок 🙂

Для просмотра позиций своих сайтов пользуюсь мегаиндексом. Петр, а чем не устраивает мегаиндекс? Какие преимущества у СЕРП парсера перед сервисом мегаиндекс?

судя по комментарию для вас никакой 🙂

Здесь отображаются урлы страниц, которые вылезли, их тайтлы и даже сниппеты. Плюс не нужно платить за каждую проверку.

Пользуюсь Sespider. По-моему, там все тоже самое что SERP Parser. Пётр, чем не устраивает Sespider? Он ведь бесплатный, хоть больше и не обновляется разработчиком.

Прочитал Исповедь Zadrota, первую часть, очень понравилось, спасибо за рекомендацию книги. Заставило задуматься, вспомнить свое время, свой путь. А вот читая, вторую часть, разочаровался, автор, на мой взгляд, потерял свою изюминку повествования, попер в какие-то детективные романы, продающиеся на вокзалах. Всё-таки порой нужно ограничиваться одной частью книги и не обещать читателям продолжения, даже если будет больше 100000 скачиваний.) Тем более, не понравилось, что вторая часть это не по-настоящему, а солянка из личных историй и историй других людей, которые он приписал герою книги.

1. Вообще первый раз слышу про программу Sespider. Просто попробовал Серп Парсер, очень понравилась.

2. Да, обычно продолжения почему-то получаются крайне редко такими же хорошими. Потому что “силом”, наверное.

Спасибо буду тестировать, со словоебом почти разобрался, пора на Коллектор скоро переходить.

КейКоллектор отличная вещь, в свое время потратил на него 1500 рублей и ни капли не жалею. Вот кстати интересный пошаговый видео урок от Пузата по настройке КейКоллектора и парсингу ключей из Яндекс.Вордстат.

Видео не совсем новое, так как с 2011 года программа обновилась наверное несколько сотен раз, но общие нюансы настройки и парсинга ключевиков там показаны отлично и еще актуальны. Вот ссылка на видео: https://www.youtube.com/watch?v=B-aNKqh4lMs

Не слабая программка отметил на будущие

Я тоже считаю megaindex.ru лучшее решение !

Я тоже купил его после КейКоллектора =)

Когда становится очень много проектов/много запросов, крайне неудобно сидеть ждать, пока снимутся позиции. У меня нет декстопного компьютера, отказался полностью от него, работаю теперь только на маке, перешел на онлайн-сервисы https://reclampa.ru/udobnaya-rabota/allpositions-proverka-pozicij-sajta.html

Добрый день! Первый раз пользуюсь программой, решил что покупать пока не буду, за 14 бесплатных дней думаю приму окончательное решение.

Суть вопроса такова. Думаю всё так же, как показано на картинках. Когда процесс сбора данных подходит к концу, во всех столбцах показывает значение 0. Пробовал другие запросы делать, результат один и тот же.

Помогите пожалуйста разобраться.

спасибо за подробную статью о работе с программой, попробовал прокси которые вы указали, но в коллекторе они не работают с гуглом. позции не снимаются сразу банятся. не подскажите какие прокси можно использовать, а то гугл жестко как то относится к ним. покупал уже прокси и все равно не помогает.

К сожалению, прокси не использую, поэтому подсказать не могу. А по поводу съема позиций перешел на Topvisor.